La nascita dell’Intelligenza Artificiale coincide con quella dei primi computer, negli anni 50. Già allora si sentiva la necessità di effettuare operazioni complesse e automatizzate senza l’intervento umano, se non dopo gli input iniziali. L’Intelligenza Artificiale è uno strumento al servizio dell’essere umano in grado di compiere analisi, prendere decisioni, aiutare nelle attività produttive. Alcune applicazioni pratiche le utilizziamo già quotidianamente, basti pensare ai navigatori stradali che possono rielaborare i percorsi in caso di traffico eccessivo, oppure nei videogame, gli scacchi ne sono un esempio classico. Altri ambienti in cui le AI vengono usate sono i suggeritori di acquisto, quando cioè su un sito di ecommerce qualsiasi compaiono altri prodotti simili a quelli che abbiamo acquistato in prima persona o che vengono proposti all’interno di un perimetro di preferenze per target di clientela. Esistono anche chatbot, sistemi di messaggistica creati per simulare una conversazione realistica con gli esseri umani in grado di rispondere a domande complesse e, addirittura, formulate con una grammatica scorretta. Alcuni siti web hanno installato questi software riconoscibili per l’icona a forma di busta da lettera anche se l’esempio più importante sono gli assistenti vocali, come quelli di Google e Amazon.

Parlare di Intelligenza Artificiale, comunque, non è così semplice. Questa tecnologia, infatti, si è sviluppata e ramificata a tal punto che dovremmo parlarne al plurale. E’ già piuttosto complicato anche farne semplicemente una storia delle origini. E’ importante, comunque, approfondire e studiare questa particolare sezione dell’informatica perché nel nostro prossimo futuro avrà sempre più importanza. Capirne i meccanismi, può aiutarci a raggiungere la consapevolezza di ciò che ci troveremo di fronte, altrimenti la considereremo al pari di una divinità capricciosa: è importante sapere che è pur sempre una programmazione che, per quanto possa essere evoluto e sofisticato, reagisce a comandi e input meccanicamente. Per quanto possa progredire, difficilmente potrà avere una etica e una morale o provare invidia, rancore, gelosia o fare i dispetti.

Quanto meno nel breve-medio termine…

Le origini dell’Intelligenza Artificiale le possiamo far risalire alla notte dei tempi, ovvero alla comparsa dell’Homo Sapiens. L’essere umano è l’unica specie vivente in grado di astrarre il pensiero, immaginare scenari, inventare soluzioni alternative, economicamente migliori, per risolvere un problema. Un cavallo di fronte a un ostacolo immaginerà, nella sua testa, quanta forza dovrà disporre per superarlo. Un branco di lupi in caccia, adotterà una strategia impressa nei geni del loro DNA. Un ragno progetta la sua tela svolgendola progressivamente. Nessun animale ha però mai pianificato comportamenti alternativi a quelli ereditati geneticamente. L’uomo ha inventato la zappa per arare più velocemente, ottenendo raccolti più abbondanti in meno tempo. Dalla zappa alle moderne tecnologie, è solo un percorso continuativo.

E’ così che sono nate le prime tecnologie ausiliari alle necessità umane.

Nel 1645, il filosofo Blaise Pascal scrisse:

“Amico lettore, questo avvertimento servirà a farti sapere che espongo al pubblico una piccola macchina di mia invenzione, per il solo mezzo della quale potrai, senza pena alcuna, fare tutte le operazioni dell’aritmetica e sollevarti dal lavoro che ti ha spesso affaticato la mente allorché hai operato per mezzo della penna”. Si trattava di una semplice, primordiale, calcolatrice, grazie alla quale Pascal poteva eseguire le operazioni matematiche più agilmente.

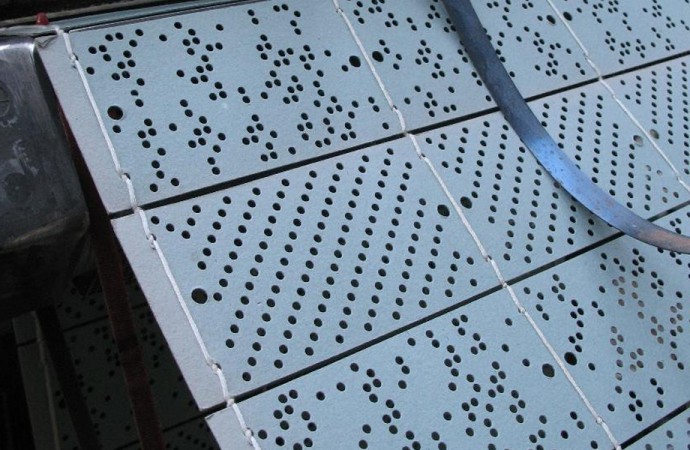

Nel 1801, nel pieno fermento della Rivoluzione Industriale, Joseph Marie Jacquard presentò un telaio tessile che movimentava automaticamente i fili del macchinario grazie a una scheda perforata che guidava il telaio nella composizione del tessuto.

“La scheda perforata è un supporto di registrazione in cui le informazioni sono registrate sotto forma di perforazioni in codice. Sono fatte di cartoncino e rappresentano l’informazione attraverso la presenza o l’assenza di fori in posizioni predefinite. Nella prima generazione di computer, dagli anni venti agli anni cinquanta, le schede perforate furono il supporto principale per l’immagazzinamento e il trattamento automatico dei dati.” ²

Non si trattava, quindi, solo di muovere una spoletta meccanicamente, grazie all’energia dei motori a vapore, ma di eseguire operazioni anche complesse che realizzavano autonomamente il prodotto finale, senza l’ausilio della forza lavoro umana. L’invenzione fu talmente geniale che modificò profondamente tutta l’industria tessile mondiale e non solo, perché un secolo e mezzo dopo, con lo stesso identico procedimento, venne convertita per il suo utilizzo in informatica.

Il funzionamento della scheda perforata si basa su un algoritmo.

Possiamo definire l’algoritmo come un procedimento sistematico di calcolo ossia una sequenza di procedure ordinate gerarchicamente.

Per esempio:

- prendere una pentola vuota

- riempirla d’acqua

- salare

- portare a bollore

- gettare la pasta

- cuocere per i minuti indicati sulla confezione

- scolare

- condire

- mangiare

Se procedessimo con il comando 7 prima dei precedenti 6, otterremo un errore di esecuzione e rimarremmo a digiuno. L’hardware e i software dei computer funzionano allo stesso identico modo: eseguono un’operazione seguendo lo schema un algoritmo che contiene delle istruzioni ordinate gerarchicamente.

Alle origini dell’Intelligenza Artificiale c’era il bisogno di creare macchine in grado di risolvere problemi che avrebbero richiesto troppo tempo ed energia per la mente umana ma, nei primi informatici sperimentatori di questa nuova tecnologia, era già chiaro che gli sviluppi avrebbero portato alla realizzazione di strumenti in grado di interagire con l’ambiente che li circondava.

La difficoltà non era nell’immaginare questo sistema, ma nei mezzi per renderlo concreto.

Furono Allen Newell e Herbert Simon a sviluppare il programma Logic Theorist, capace di risolvere autonomamente alcuni teoremi matematici contenuti nei Principia Mathematica di Alfred North Whitehead e Bertrand Russell.

Allen Newell si occupava, invece, di fisica, matematica, informatica e psicologia cognitiva. Herbert Simon era un ricercatore specializzato in economia, psicologia e informatica. Nel 1947, Simon pubblicò il libro “Il comportamento amministrativo” nel quale analizzava il modo in cui i dirigenti di un azienda arrivano a prendere una decisione e qual è il procedimento mentale che li porta a decidere cosa fare.¹ Da questa riflessione, prese spunto per formulare le prime teorie sui modelli computazionali, comportamentisti e connessionisti artificiali.

Alan Turing lo conosciamo un po’ di più dei primi due, se non altro perché dalla sua vita e dalle sue geniali intuizioni ne fu tratto un famoso film: The Imitation Game del 2014. Il contributo dato all’informatica e all’evoluzione dell’Intelligenza Artificiale è talmente importante che ancora oggi il test che porta il suo stesso nome, migliorato ma non sostituito negli anni successivi, è fondamentale per distinguere un calcolatore informatico da una mente pensante.

Ad oggi, nessuna macchina ha superato il “gioco dell’imitazione”.

Gli interessi di John Von Neumann si espandevano nei territori di matematica, ingegneria chimica, idrodinamica, balistica, meteorologia, statistica, logica, fisica quantistica. Entrò nel progetto Eniac e poco dopo la fine della Seconda Guerra Mondiale elaborò lo schema che ancora oggi è usato per assemblare i computer. Questo schema si fonda su quattro componenti fondamentali:

- l’unità centrale di elaborazione (CPU)

- l’unità di memoria di massa, come lo sono le chiavette USB o gli hard disk, per intenderci.

- l’unità di input, per esempio una tastiera

- l’unità di output, lo schermo.

Von Neumann nel 1958 scrisse il libro “Computer e cervello” nel quale dimostrava somiglianze e differenze tra questi due sistemi operativi con intuizioni che sono state poi confermate dalla moderna neurobiologia. Sia il cervello che l’unità centrale di elaborazione eseguono operazioni seguendo una schema algoritmico. Gli psicologi comportamentisti ci dicono infatti che i nostri comportamenti sono standardizzati al 90-95%. In pratica ci comportiamo tutti allo stesso modo, salvo una piccola percentuale che, infatti, viene considerata strana oppure soffre di gravi patologie psichiche. Per quanto faccia orrore una teoria di questo tipo e generi repulsione, dobbiamo infatti notare che le nostre abitudini e le nostre interazioni sociali, seguono modelli piuttosto stereotipati. Non significa negare che a qualcuno piaccia la pizza piuttosto che il cioccolato. Significa che i nostri gusti, le nostre scelte, le nostre opinioni, la nostra moralità, si fondano su istinti genetici, esattamente come negli animali, che hanno un minimo denominatore comune. E’ solo con la nostra provenienza geografica, culturale, economica e sociale che si realizzano le differenze che caratterizzano i comportamenti individuali. Partendo da questo presupposto, scienziati, ricercatori e informatici hanno creato lo schema per sviluppare l’Intelligenza Artificiale.

Possiamo riassumerlo in quattro punti essenziali:

- percezione

- apprendimento

- ragionamento

- interazione

Così facendo, le ricerche e l’evoluzione sulle IA, nel corso dei decenni, sono giunte alla realizzazione di macchine pensanti, capaci di conformarsi all’ambiente ed effettuare scelte basate anche sulle esperienze pregresse, in modo autonomo. E’ il cosiddetto Machine Learning.

Il Machine Learning non è solo la capacità adattativa di pescare dalla memoria i ricordi utili per superare un problema e articolare una strategia alternativa. Per esempio:

- prendi il pane

- taglialo a metà

- inserisci le fette di salame

- mangia.

Questa operazione può essere effettuata anche in un altro modo:

- prendi le fette di salame

- spezza il pane

- mangia

Una IA forte, invece, non solo utilizza il modello computazionale legato alle informazioni ricevute, ma è anche in grado di connettersi e interagire con l’ambiente esterno utilizzando schemi comportamentali e cognitivi simili ai processi mentali umani. La differenza tra le IA e i nostri normali computer, è che questi ultimi funzionano solo se inseriamo correttamente i comandi necessari al loro funzionamento, non sono autonomi, al contrario delle IA che, una volta programmate, possono lavorare indipendentemente dai comandi immessi dall’essere umano.

A lungo andare, potrei modificare questo algoritmo in base all’analisi nutrizionale degli ingredienti e sostituire un alimento gustoso ma, a lungo andare, nocivo per la mia salute come il salame con un ingrediente più salutare, per esempio delle fette di pomodoro. Questa capacità di analisi, verifica, memorizzazione, pianificazione, adattamento è ciò che distingue un’Intelligenza Artificiale forte da una Intelligenza Artificiale debole. Una IA debole esegue solo calcoli complessi come la rielaborazione dei dati ricavati dai cookies, per esempio. E’ un numero talmente gigantesco che un essere umano non sarebbe in grado di analizzare in una vita intera. Una IA può farlo al suo posto.

La IA e il Machine Learning, negli ultimi anni, hanno conosciuto una evoluzione formidabile, esistono già numerose applicazioni su larga scala, come il riconoscimento facciale, il controllo di qualità dei prodotti, la manutenzione intelligente. Ad oggi, però, nessuna IA è comunque riuscita a superare il test di Turing, il tempo in cui le macchine pensanti si ribelleranno all’umanità, come nei “Blade Runner”, “Odissea nello spazio” o nel libro “Negromante” di William Gibson.

Piuttosto, inquieta di più un altro aspetto dell’Intelligenza Artificiale: l’enorme capacità computazionale potrà, prima o poi, considerare le infinite variabili che governano lo sviluppo del mondo naturale, per esempio come cresce una pianta in determinate condizioni climatiche e di esposizione solare. Anche i nostri comportamenti, come detto in precedenza, seguono logiche meccanicistiche intimamente darwiniane, sulle quali si innestano le variabili ambientali individuali.

C’è, quindi, il rischio che l’Intelligenza Artificiale possa risolvere l’enigma di queste variabili, cancellando il futuro.

¹ – http://www.istitutocalvino.gov.it/studenti/siti/ia/protagonisti/simon.html